La crescente adozione di sistemi basati sull’intelligenza artificiale ha evidenziato come l’utilizzo di particolari algoritmi porti con sé alcune problematiche di stampo razzista. È necessaria una premessa importante: le applicazioni e i sistemi di intelligenza artificiale basati sull’apprendimento automatico, sfruttano i cosiddetti big data per il loro “addestramento”. Si tratta di montagne di informazioni che vengono date in pasto agli algoritmi, i quali le utilizzano per imparare a produrre output di un certo tipo.

Il futuro si sta evolvendo verso un’economia basata sui dati e sull’innovazione portata dai sistemi di intelligenza artificiale. Tutto ciò aprirà le porte a nuove opportunità per i privati, le imprese e la ricerca. Tuttavia queste tecnologie portano con sé rischi e lati negativi da contrastare e tenere sotto controllo.

I grandi set di dati e l’analisi predittiva dovrebbero, infatti, riflettere una sola verità: quella oggettiva. I numeri dovrebbero parlare da soli. Tuttavia, alcuni scienziati e ricercatori sembrano avere da ridire. Effettivamente, analizzando alcuni casi particolari, sembra che esista una sorta di soggettività, che può addirittura sfociare in episodi di vero e proprio razzismo.

Sommario:

Le distorsioni inerenti ai Big Data

“Con grandi quantità di dati i numeri parlano da soli“

Chris Anderson

Le dichiarazioni dell’ex caporedattore di Wired sono condivise dai sostenitori della verità oggettiva nei big data. Essi ribadiscono il concetto per il quale le grandi quantità di dati resi disponibili ai computer permettono loro di avvicinarsi il più possibile ad una quasi totale oggettività durante i processi decisionali.

Kate Crawford si schiera contro la veridicità di tali affermazioni. Secondo la ricercatrice di Microsoft Research, i big data riportano gli stessi pregiudizi presenti all’interno delle varie culture globali. Insegnando alle macchine a discriminare esattamente come gli esseri umani, il razzismo perpetua negli algoritmi. I dati derivano direttamente dalle persone che, come sappiamo, da sempre mettono in atto meccanismi di discriminazione.

Come possono quindi i set di dati essere oggettivi? Sono “creazioni umane” e per quanto credere al contrario, in realtà esistono infiniti pregiudizi nascosti, sia nella fase di raccolta che in quella di analisi. Gli esseri umani danno ai numeri la propria voce, ne traggono deduzioni e ne definiscono il significato attraverso interpretazioni puramente soggettive.

Questione di input

Per quanto per le loro caratteristiche possano sembrare astratti, non bisogna dimenticare che i grandi dataset sono legati profondamente al luogo fisico e alla cultura di provenienza. Particolari categorie della popolazione e regioni geografiche danno origine a pochi o assenti input, generando lacune significative nella raccolta dei dati.

I gruppi con basso reddito, ad esempio, hanno meno probabilità di possedere uno smartphone o un computer, così come le categorie dei più anziani. Questo significa che i dati raccolti attraverso questi dispositivi mancano di una parte di input.

Ne consegue che i big data non sono rappresentano tutta la popolazione o l’intero gruppo geografico considerato. Non siamo ancora arrivati ad una distribuzione totale e omogenea dei dispositivi. Questo impedisce di generalizzare i risultati statistici sulla totalità del campione in esame, in quanto incompleto alla fonte.

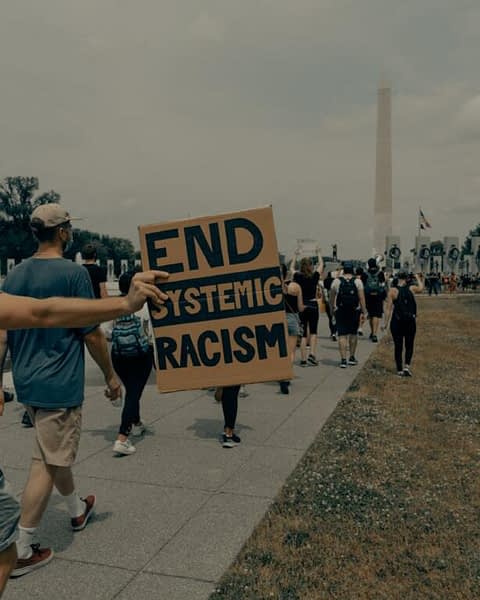

Queste problematiche, tuttavia, non necessariamente scompariranno con l’aumento di produzione delle tecnologie digitali. Viviamo infatti in un’era in cui si corre il rischio che le disuguaglianze già esistenti si consolidino ulteriormente. Il fenomeno del razzismo ne è esempio lampante: esso ancora vive nella società, malgrado la crescita sociale e le politiche attuate per contrastare il fenomeno. Gli algoritmi delle intelligenze artificiali non ne tengono conto, e se nei dati sono presenti pregiudizi ne amplificano l’effetto.

È importante sottolineare la questione della disparità di accesso al mondo digitale. In questo senso, fare affidamento più frequentemente ai big data significa mettere in conto una serie di eventualità e problematiche. L’utilizzo dei grandi dataset porta benefici per la popolazione globale, ma anche il rischio di fraintendere i risultati ed utilizzarli erroneamente come importante risorsa pubblica.

Le disuguaglianze sociali si riflettono quindi direttamente sulle tecnologie e l’utilizzo di dati disomogenei, errati o con caratteristiche invalidanti, ne abbassa notevolmente l’utilità.

Algoritmi che apprendono

I software su cui sono costruite le IA apprendono analizzando i dati. Questo processo viene chiamato apprendimento automatico: permette al software di modificare il proprio comportamento, adattandosi alle situazioni in modo molto simile a quello umano. Nello specifico, viene definito come un insieme di meccanismi che permettono ad un sistema intelligente di migliorare le proprie capacità e prestazioni nel tempo. Esistono diversi campi d’azione dell’apprendimento automatico, ma la cosa che li accomuna è la necessità di dati con cui migliorare o approfondire la conoscenza della macchina.

Gli algoritmi di apprendimento automatico sono oggi utilizzati in tutto ciò che ci circonda. Amazon, ad esempio, li usa per comprendere le abitudini d’acquisto dei clienti e proporre annunci mirati più accurati. Netflix li utilizza per capire i gusti dell’utente, così da raccomandare in modo efficace nuovi contenuti. Altri esempi diffusi sono le tecnologie di riconoscimento vocale presenti negli smartphone, la guida autonoma delle più recenti automobili, che include il riconoscimento di immagini e del contesto ambientale.

Algoritmi che discriminano

Le decisioni prese dagli algoritmi di apprendimento automatico sono complicate e difficilmente comprensibili agli occhi degli esseri umani. Questo rende quasi impossibile identificare una linea di codice che possa effettivamente portare a qualche tipo di discriminazione effettiva.

All’interno di un podcast, a cui ha partecipato anche la ricercatrice Kate Crawford, Suresh Venkatasubramanian – professore associato dell’Università dello Utah – riporta come nella sua esperienza abbia constatato che le persone siano erroneamente convinte che gli algoritmi siano solo codici e che facciano solamente ciò che gli viene detto.

“Gli algoritmi discriminano […] i Big Data […] sono sistematici, diamo per scontato che siano in qualche modo più oggettivi degli esseri umani. È sorprendente vedere come si possano avere gli stessi elementi di distorsione che si hanno negli esseri umani, sia nei Big Data che negli algoritmi stessi.”

Suresh Venkatasubramanian – Why Machine Discriminate and How to Fix Them

Il ricercatore afferma è che gli algoritmi effettuano discriminazioni proprio perché inerentemente possiedono un tasso di distorsione, risultato della soggettività delle persone che hanno contribuito alla costruzione dei set di dati considerati.

L’approccio ai dati

Lo stesso Venkatasubramanian sostiene l’enorme importanza di porsi alcune semplici domande che possono aiutare ad evitare errori interpretativi, quando si lavora con grandi set di dati:

“Quali metodi sono stati usati per raccogliere e analizzare quei dati?”, “Quali pregiudizi cognitivi potrebbero portare alla loro interpretazione scorretta?“

Come indicato da Kate Crawford, è necessario lavorare con i big data tenendo in considerazione i risultati ottenuti con studi di dati più piccoli. Questo permette di osservare i cambiamenti decisionali degli algoritmi, sulla base dei dati in input, rendendo più facile l’individuazione di eventuali distorsioni.

Esistono metodi che permettono di aggiungere profondità ai dati raccolti. Integrando la pluralità di fonti con una rigorosa ricerca qualitativa si riescono ad ottenere dati tridimensionali. Ad esempio conducendo interviste semi-strutturate abbinate a tecniche di recupero delle informazioni.

Per tentare di riparare alle disparità dei big data è necessario affidarsi a metodologie che danno la precedenza alla qualità delle informazioni. Processo che può allungare la fase di analisi e di raccolta dati, ma migliorarne notevolmente la correttezza interpretativa.

Cosa sono gli algoritmi?

Una ricetta di cucina. Questo è quello che racconta sugli algoritmi Venkatasubramanian. Il professore afferma che una definizione di algoritmo meno intimidatoria rispetto a quella classica potrebbe essere proprio quella della tipica ricetta di cucina.

“Un algoritmo è come una ricetta. Prende input, ovvero gli ingredienti, esegue un insieme di passi semplici e ben definiti, e poi termina dopo aver prodotto un output, ovvero il pasto.”

Suresh Venkatasubramanian

C’è un unico problema con questa definizione: è assolutamente sbagliata se ci si riferisce all’universo degli algoritmi che definiscono l’apprendimento automatico.

La ricetta di cucina si può applicare come definizione a praticamente tutti gli algoritmi, ma non a quelli legati al machine learning. Ebbene sì, ciò che sembrava così semplice è sbagliato se applicato alla definizione di algoritmo su cui si basa un sistema di IA. La comune concezione di algoritmo non funziona per l’apprendimento automatico: essa è basata più similmente sulla procedura per COSTRUIRE una ricetta di cucina.

L’algoritmo applicato al machine learning non è la ricetta: è il meccanismo mentale per costruire la ricetta!

“Un algoritmo di apprendimento non è una ricetta. È una procedura per costruire una ricetta, un gioco di roulette su una ruota a cinquanta dimensioni che atterra su un punto particolare, la ricetta. Esso è basato interamente su come è stato addestrato, quali esempi ha visto e quanto tempo ci ha messo, successivamente, a cercare. In ogni caso, la pallina atterra su una risposta accettabile, ma queste risposte sono molto diverse fra loro e spesso non hanno molto senso per chi le esegue.”

Suresh Venkatasubramanian

Comprendere le intelligenze artificiali

Avendo a disposizione una lista di ingredienti e la volontà di imparare una ricetta partendo da zero, senza nessuna indicazione, come vi comportereste? Saprete certamente di dover combinare gli ingredienti elencati all’interno della lista, ma non in che modo farlo.

Dovremo cercare la combinazione più logica per noi, ma se non annotiamo i passaggi seguiti è probabile che la volta dopo uniremo gli ingredienti in una maniera differente, rischiando addirittura – in certi casi – di ottenere un risultato diverso.

Questo discorso è necessario per comprendere come, anche con lo stesso input, il risultato potrebbe essere diverso se si seguono passaggi differenti. Come se non si stessero seguendo quelli indicati nella ricetta.

Una persona che ci osserva cucinare coglierà e comprenderà ogni singolo passaggio, ma rimarrà all’oscuro sul perché abbiamo svolto proprio quello anziché un altro. Lo stesso discorso vale per il codice: fa ciò che fa. Capire perché abbia effettuato un certo passaggio anziché un altro è praticamente impossibile. Le motivazioni rimarrebbero comunque molto difficili da comprendere a occhi “estranei”, anche conoscendo la sua evoluzione e le esperienze “vissute”

La maggior parte delle persone è erroneamente convinta che il codice degli algoritmi faccia semplicemente ciò che gli viene detto. Il problema risiede nel fatto che gli algoritmi di apprendimento automatico non eseguono delle istruzioni atte a produrre un risultato dato. Sono ad un livello più profondo rispetto alla tipica sequenza di istruzioni imperative che può rappresentare una ricetta di cucina. Questi sistemi vengono addestrati “studiando” innumerevoli risultati, per sviluppare delle procedure con cui agire in maniera autonoma per ottenere un risultato simile. Con le opportune semplificazioni, possiamo dire che questi sistemi funzionino esattamente come le persone che tutti i giorni compiono delle azioni cercando di ottenere dei risultati non scontati.

Un esempio esplicativo è quello dell’installazione di Mario Klingemann, Memories Passerby I, descritta nel nostro articolo “GAN: l’algoritmo che imita la creatività”. L’IA è stata istruita con un set di dati composto da migliaia di dipinti realizzati tra il 1700 e il 1800. Non attinge a un database. Essa genera autonomamente opere d’arte in base a ciò che ha imparato dall’addestramento. Ad ogni esecuzione, mette in atto un flusso sempre differente e mai ripetuto di dipinti auto-generati.

In che modo l’IA decide come proporre al fruitore il flusso di dipinti? Quali scelte compie nell’ordine di presentazione e di generazione? Si tratta di domande a cui non è possibile dare una risposta esplicativa, a causa della natura non completamente predicibile del sistema di IA.

Algoritmi sempre più umani

“L’ironia è che più progettiamo tecnologie di intelligenza artificiale che imitano con successo gli esseri umani, più le IA imparano in un modo simile al nostro, con tutti i pregiudizi e limiti tipici della razza umana.”

Suresh Venkatasubramanian

Gli algoritmi appaiono ai nostri occhi come sistemi non dotati di pregiudizi, perché basati su codice informatico per giungere alle loro conclusioni. Ma non è così: i dati e gli algoritmi sono soggetti a distorsioni. Più gli algoritmi imitano in modo simile gli essere umani, più i comportamenti risultano essere inspiegabili, come guidati “dall’istinto”.

Come abbiamo già visto, i big data su cui vengono addestrate le intelligenze artificiali, possono essere soggetti a distorsioni. Questo si identifica nei sistemi di apprendimento automatico con risultati discriminanti. L’uomo è naturalmente soggetto a pregiudizi e convinzioni. Pensare che possa produrre dei training set neutrali e privi di distorsione è pura illusione. Le IA allenate con dati di questo tipo, tenderanno sempre a comportarsi come gli esseri umani, cioè con almeno un piccolo livello di pregiudizio.

L’apprendimento automatico

Alla base delle discriminazioni e dei pregiudizi introdotti dalle IA nelle loro decisioni, sembra esserci l’algoritmo di apprendimento automatico. Ma se i risultati di un algoritmo, relativi magari all’assunzione del personale o all’approvazione di prestiti bancari, sono soggetti a pregiudizi e discriminazioni, possiamo affermare che la colpa non sia solo sua.

Un team di informatici, guidati da Venkatasubramanian, composto da membri provenienti dall’Università dello Utah, dall’Università dell’Arizona e dall’Haverford College, ha scoperto un modo per capire se un algoritmo decisionale effettivamente discrimini o meno.

Questa tecnica permette inoltre di capire se la discriminazione sia volontaria o meno. Quasi sicuramente vi starete chiedendo come un IA possa discriminare volontariamente. Questo avviene quando l’addestramento infonde nel software un comportamento discriminatorio sistematico, dovuto ad esempio alla definizione di un modello basato su dati di training distorti. Tuttavia i pregiudizi possono nascere in maniera involontaria quando il comportamento si basa esclusivamente su un’interpretazione distorta dei dati che sono stati utilizzati nello sviluppo della IA stessa.

Rilevare una discriminazione

Per capire se i risultati prodotti da un IA contengono delle discriminazioni, si effettua un test che sfrutta a sua volta un algoritmo di apprendimento automatico. Se l’algoritmo di supporto è in grado di prevedere con precisione la razza e/o il sesso di un determinato individuo preso in esame, allora certamente l’IA analizzata effettuerà delle discriminazioni. Questi dati, infatti, dovrebbero essere nascosti all’interno del database a disposizione dell’algoritmo e quindi inutilizzabili per prendere una decisione.

I ricercatori guidati da Venkatasubramanian, hanno realizzato uno studio da cui emerge che intere categorie sono soggette a discriminazioni da parte delle IA. Dagli afroamericani alle donne. Un pieno razzismo degli algoritmi.

Risolvere questo problema è possibile attraverso la redistribuzione dei dati, cioè escludendo dall’analisi quelle informazioni che, se combinate con altre, potrebbero creare discriminazione.

Secondo Kate Crawford, per capire le motivazioni di queste discriminazioni e analogamente trovare la soluzione del problema, è essenziale analizzare il comportamento degli algoritmi, testandoli su sottoinsiemi dei dataset originari. Questo aiuterebbe anche a studiare meglio i risultati prodotti in base anche alle diverse categorie di persone a cui sono stati applicati. Successivamente è possibile formulare un modello matematico di descrizione dei pregiudizi, con cui modificare le modalità di azione e mantenere equità.

Il razzismo artificiale

Molte realtà sono soggette al razzismo degli algoritmi di IA. Questi sistemi, infatti, operano all’interno di una grande varietà di imprese e istituzioni, affiancando l’uomo nei processi decisionali. Fattori oggettivi possono diventare caratteristiche su cui fare discriminazione, in quanto gli algoritmi eseguono ciò che hanno imparato dalle direttive di chi li ha istruiti.

Algoritmi di assunzione

Un’IA potrebbe facilitare il lavoro di analisi dei curriculum, identificando ipotetiche caratteristiche legate a fattori personali. Immaginiamo, ad esempio, che uno di questi sistemi associ un font a bassa produttività e che lo consideri quindi come un indice di pigrizia e scarsa propensione al lavoro. L’IA scarterebbe quel curriculum e quella persona considerandola inadeguata esclusivamente a causa di una scelta stilistica. Sembra qualcosa di distopico, ma potrebbe realmente accadere.

Tipicamente un recruiter considera come fattore rilevante la distanza del dipendente dal luogo di lavoro. È infatti dimostrato statisticamente che il pendolarismo, a lungo andare, porti maggiori probabilità di dimissioni o licenziamento. Una persona, tuttavia, può considerare questi fattori con un grado di riserva poiché un lavoratore può scegliere anche di trasferirsi più vicino, dopo aver ottenuto il lavoro. Per un IA l’indecisione si trasforma in probabilità sulle circostanze che può operare una discriminazione non poco rilevante, e risultare decisiva per scartare la candidatura.

Molte aziende si affidano agli algoritmi automatici per intraprendere processi decisionali. Il motivo principale risiede proprio nell’erronea idea che siano privi da qualsiasi tipologia di discriminazione.

Ad esempio vengono comunemente utilizzate dei software di intelligenza artificiale per effettuare una scrematura iniziale dei candidati ad una nuova assunzione. Durante questo processo è filtrare i candidati abbastanza velocemente. Analizzarli uno ad uno richiederebbe invece molto tempo. Un algoritmo di supporto può invece ricercare tramite parole chiave e assegnare un punteggio complessivo per ogni candidato, scartando i curriculum vitae con punteggio troppo basso. Le problematiche sorgono, però, quando si tratta di fare i conti con quello che l’IA decide di prendere in considerazione come elemento di calcolo del punteggio.

Aspetti psicologici

Già da circa 10 anni, l’aumento del flusso di domande di lavoro, ha obbligato le grandi aziende ad adottare sistemi di automazione che agiscano nel processo di selezione in maniera più approfondita. Se prima questi sistemi si limitavano ad analisi testuali, oggi si sono evolute con quiz, test psicometrici, giochi e chatbot che respingono i candidati ancora prima che un essere umano visualizzi la loro candidatura.

HireVue è una società che si occupa della realizzazione e vendita di software per l’analisi dei curriculum dei candidati. Il suo prodotto è ufficialmente utilizzato da importanti aziende come Goldman Sachs, una delle banche d’affari più grande al mondo. I candidati che vengono analizzati dalla piattaforma di HireVue devono rispondere alle domande del colloquio di fronte ad una telecamera e il linguaggio del corpo viene esaminato da un team di psicologici. Attraverso l’analisi vocale, l’analisi delle micro-espressioni del viso e del linguaggio del corpo, vengono studiate la personalità e la capacità dei candidati. I risultati vengono dati in pasto ad un IA che assegna un punteggio in base all’input e successivamente lo confronta con i migliori punteggi dei dipendenti assunti.

Secondo Nathan Mondragon, capo psicologo di HireVue:

“Trovare l’impiegato giusto significa guardare le piccole cose.”

Nathan Mondragon

L’idea di questo software si basa sul fatto che punteggi simili potrebbero avere le stesse potenzialità. Di conseguenza, assumendo un candidato che ha un punteggio simile ad un ottimo dipendente sarà molto probabile ottenere un altro ottimo dipendente. Non si tratta di un processo disumanizzante? Come si ripercuote l’uso di questi sistemi sulla psicologia delle persone?

Problemi nell’assumere con le IA

In Inghilterra i sistemi di analisi dei candidati sono ampiamente utilizzati dalle aziende. È molto comune trovare annunci che richiedono al candidato il completamento di quiz, giochi o test. Se si viene scartati dall’algoritmo non sarà prevista nessuna interazione successiva con il datore di lavoro o con un recruiter. Il rifiuto della IA toglie ogni possibilità di assunzione al candidato. In questo modo avviene una disintegrazione di qualsiasi tipologia di scambio umano tra gli individui.

Questo processo toglie anche la possibilità di comprendere cosa si stia sbagliando nella compilazione del proprio curriculum o cosa si stia sbagliando a livello personale nella ricerca di un lavoro. Dato che non è possibile conoscere quale siano le qualità che il sistema ricerca nei candidati e quali siano quelle motivo di esclusione.

La tipica paura che l’automazione e i sistemi di IA sostituiscano il proprio lavoro, lascia spazio, per coloro che affrontano questa tipologia di selezione, alla preoccupazione di essere scartati da un’intelligenza artificiale, potenzialmente soggetta a distorsioni. È possibile aggirare in qualche maniera questi meccanismi di assunzione? Le ripercussioni psicologiche sui candidati sono davvero così preoccupanti?

Gli individui che vengono rifiutati ripetutamente possono ovviamente cadere in uno stato di frustrazione. Nasce nei candidati un sentimento che abbatte la loro voglia di combattere per il futuro. Che li fa sentire affranti e nemmeno degni dell’attenzione di un recruiter umano, anche solo per qualche minuto.

Quale potrebbe essere la soluzione a questa problematica? Con ogni probabilità certamente non quella di cercare metodi per aggirare i sistemi di selezione, tuttavia il web si ritrova stracolmo di consigli su come aggirare i sistemi e passare le selezioni. Utenti che condividono pubblicamente le proprie risposte ai quiz per aiutare altri individui a superarli. Altri che si valutano tra loro e si danno dei punteggi per migliorarsi in previsione dell’invio di candidature.

Mya: un’alternativa più umana?

Eyal Grayevsky, CEO di Mya Systems, ha creato un sistema di analisi di candidature che prende il nome di Mya. È un sistema basato su cloud, pensato per integrarsi in un qualsiasi preesistente software utilizzato per le assunzioni.

Mya offre un’interazione molto simile a quella umana, permettendo ai candidati di beneficiare di risposte ai propri dubbi. Può essere inoltre utilizzata per affidare ai dipendenti i lavori più adatti in base alle loro caratteristiche. Se non soggetta a distorsioni, spesso si è rivelata addirittura più oggettiva e più adatta nel ricercare dipendenti in determinati ambiti rispetto ad un essere umano.

Mya non è un sistema che effettua l’analisi e scarta il candidato in base a dei criteri prefissati. Si tratta piuttosto di un chatbot che permette di ottenere in tempo reale risposte alle domande. È un sistema con cui il candidato può e deve “obbligatoriamente” interagire. Quando una candidatura viene analizzata da Mya, l’interazione è assicurata.

Il sistema offre una breve presentazione di sé ed intraprende una conversazione con il candidato, composta da una serie di domande, come ad esempio:

- “Sei in grado di gestire i requisiti fisici dati dal lavoro?”

- “Quali sono le tue disponibilità in ambito di turni?”

Mya avvia una valutazione linguistica delle risposte del candidato. I risultati vengono inseriti in una scheda di valutazione che viene inviata al datore di lavoro insieme alla trascrizione dell’intera conversazione. Nel caso in cui il candidato risulti compatibile, il sistema organizzerà un colloquio con il responsabile delle assunzioni. In caso contrario verranno suggerite al candidato altre posizioni lavorative rilevanti in base a quanto ottenuto dall’analisi del colloquio.

Possiamo dunque affermare che Mya rappresenti effettivamente una svolta nell’automazione dei sistemi di valutazione delle candidature? Una cosa è certa: le sue peculiarità la rendono per adesso l’alternativa migliore. La sua particolare architettura, che permette una vera e propria interazione, dà la possibilità di far scomparire, almeno in parte, quel senso di disumanizzazione che pervade i candidati che si ritrovano rifiutati senza apparente spiegazione, e talvolta senza nemmeno essere avvisati

Pregiudizi razziali negli algoritmi sanitari

Uno studio collaborativo tra l’University of California, il Department of Medicine di Boston, il Mongan Institute Health Policy Center e la Booth School of Business di Chicago ha rivelato il razzismo dilagante nel software decisionale utilizzato dagli ospedali statunitensi.

Un algoritmo ampiamente utilizzato negli ospedali statunitensi per allocare l’assistenza sanitaria ai pazienti ha sistematicamente discriminato le persone di colore. Il sistema calcolava meno probabilità di indirizzare gli afroamericani – rispetto ai caucasici ugualmente malati – a programmi assistenziali per pazienti con esigenze mediche complesse. L’algoritmo era utilizzato negli Stati Uniti da ospedali e assicurazioni per gestire il flusso di richieste e indirizzamento all’assistenza di circa 200 milioni di persone ogni anno.

“Questo tipo di studio è raro, poiché i ricercatori spesso non possono accedere ad algoritmi proprietari e ai dataset sanitari sensibili necessari per effettuare test completi”

Milena Gianfrancesco

Questo è quanto affermato da Milena Gianfrancesco, epidemiologa dell’Università della California, San Francisco, che ha studiato le fonti di discriminazione all’interno delle cartelle cliniche elettroniche. Studi più piccoli e rapporti aneddotici hanno documentato un processo decisionale ingiusto e parziale da parte di algoritmi utilizzati in molti settori, dalla giustizia penale all’istruzione e all’assistenza sanitaria.

“È allarmante. Abbiamo bisogno di un modo migliore per valutare effettivamente la salute dei pazienti.”

Milena Gianfrancesco

Ziad Obermeyer, un ricercatore che studia apprendimento automatico e gestione dell’assistenza sanitaria presso l’Università della California, e il suo team, si sono ritrovati faccia a faccia con la problematica mentre esaminavano l’impatto dei programmi per fornire una migliore supervisione medica alle persone con complicazioni di salute multiple.

Razzismo di default

Quando Obermeyer e colleghi hanno eseguito controlli statistici di routine sui dati di un grande ospedale, sono rimasti sorpresi nello scoprire che alle persone auto-identificatesi come di colore venivano assegnati punteggi di rischio inferiori rispetto alle persone bianche ugualmente malate. Di conseguenza, i primi avevano meno probabilità di essere indirizzate a programmi di cura personalizzata.

I ricercatori hanno scoperto che l’algoritmo assegnava punteggi di rischio sulla base dei costi sanitari totali maturati in un anno. Questa ipotesi, secondo i proprietari del sistema, sembrava ragionevole perché i costi sanitari più elevati sono generalmente associati a maggiori esigenze di cure. Infatti la persona di colore media, nel set di dati utilizzato dagli scienziati, aveva costi sanitari complessivi simili a quelli della persona bianca media.

Uno sguardo più attento ha tuttavia rivelato che le persone di colore in media sono sostanzialmente più malate della media delle persone bianche, con una maggiore prevalenza di condizioni come diabete, anemia, insufficienza renale e ipertensione. Considerati insieme, i dati ottenuti dai controlli hanno mostrato che le cure fornite agli afroamericani costano in media 1.800 dollari in meno all’anno rispetto alle cure fornite a una persona bianca con lo stesso numero di problemi di salute cronici.

Gli scienziati hanno ipotizzato che questo accesso ridotto alle cure sia dovuto agli effetti di una distorsione sistematica dei dati. Distorsione data dalla sfiducia delle minoranze nei confronti del sistema sanitario e alla discriminazione razziale diretta da parte degli operatori sanitari.

E poiché l’algoritmo assegnava le persone a categorie ad alto rischio sulla base dei costi, questi pregiudizi sono stati trasmessi e amplificati nei loro risultati. Con la conclusione che le persone di colore dovevano essere più malate dei bianchi prima di essere indirizzati per ulteriore aiuto. Solo il 17,7% dei pazienti assegnati dall’algoritmo a cure “extra” erano afroamericani. I ricercatori hanno inoltre calcolato che la proporzione sarebbe stata del 46,5%, se l’algoritmo fosse stato imparziale.

Uno scarto di quasi il 30%, un numero che fa davvero paura. Immaginate cosa deve voler dire rientrare in quella percentuale. Sembra quasi essere la trama di un film distopico.

“L’utilizzo della previsione dei costi per prendere decisioni sul coinvolgimento dei pazienti è un problema pervasivo. Questo non è un problema con un algoritmo o una società: è un problema con il modo in cui il nostro intero sistema affronta questo problema”

Ziad Obermeyer

Soluzione al razzismo algoritmico

Obermeyer e il suo team hanno riferito i loro risultati agli sviluppatori dell’algoritmo, Optum. La società di Eden Prairie, nel Minnesota, ha allora ripetuto la stessa analisi, riscontrando gli stessi risultati. In seguito all’accaduto, i ricercatori si sono messi a lavorare gratuitamente per migliorare l’algoritmo, collaborando con l’azienda per identificare variabili differenti da quella dei costi sanitari che potrebbero essere utilizzate per calcolare le esigenze mediche di una persona. Dopo aver corretto l’algoritmo apportando queste modifiche, sono riusciti a ridurre la distorsione dell’84%.

La società Optum ha dichiarato di aver apprezzato il lavoro dei ricercatori, sottolineando però come le loro conclusioni fossero “fuorvianti” poiché il modello di costo è solo uno dei tanti elementi utilizzati per selezionare i pazienti dei programmi di coinvolgimento clinico. Tra gli altri elementi è inclusa, soprattutto, l’esperienza del medico.

Obermeyer afferma che trovare soluzioni per i pregiudizi negli algoritmi, oltre che nell’assistenza sanitaria, non è semplice:

‘Queste soluzioni sono semplici nel senso dell’ingegneria del software: devi semplicemente rieseguire l’algoritmo con un’altra variabile […] Ma la parte difficile è: qual è l’altra variabile? Come aggirare i pregiudizi e le ingiustizie inerenti a quella società?’

Ziad Obermeyer

Una problematica che, a quanto pare rischia quindi di non poter essere risolta.

Il razzismo degli algoritmi sul web

È ben noto che i social network utilizzino sistemi automatici per gestire l’enorme mole di contenuti. Anche questi sistemi, però, sono basati su algoritmi di apprendimento che favoriscono un certo tipo di elementi rispetto ad altri.

In questo caso il pregiudizio potrebbe non essere insito nel sistema, ma voluto. Pochi mesi fa, ad esempio, il social network Instagram è finito sotto l’indagine di AlgorithmWatch, che ha individuato come la piattaforma prediliga mostrare nelle bacheche degli utenti una certa tipologia di foto: quelle in cui i soggetti vengono mostrati abbastanza svestiti.

La discriminazione è strettamente legata a motivi economici, maggiore visibilità e sensazionalità si traduce facilmente in maggiori e veloci guadagni. Di conseguenza questo sistema opera una sorta di “selezione” dei contenuti da rendere più importanti. Ciò non solo lede la neutralità della piattaforma, ma rappresenta un precedente dannoso che potrebbe invogliare altre piattaforme ad operare nello stesso modo. Se tutti i social avessero categorie preferite da mostrare rispetto alle altre, quale sarebbe la libertà di espressione che offrirebbero?

Il caso delle foto di Twitter

Rimanendo in tema di social network, un gruppo di utenti di Twitter ha scoperto come l’algoritmo della piattaforma attui del razzismo nel creare le anteprime delle foto. Il sistema favorisce infatti il focus sui volti bianchi rispetto a quelli di colore. Il fenomeno è stato reso evidente condividendo fotografie ritraenti entrambe le persone. Molti utenti hanno dato prova della discriminazione esattamente in questo modo. In nessuna fotografia sembrava infatti esserci un comportamento diverso nel sistema.

La rete neurale di Twitter, che ritaglia automaticamente le immagini allegate ai tweet, aveva mostrato altri problemi fin dalla fase del suo sviluppo iniziale. Nella discussione riguardante il problema è intervenuta ufficialmente anche la società, prima con Dantley Davis, CDO dell’azienda, e poi attraverso Liz Kelley, membro del team comunicazione. Secondo Davis, il problema non esisteva e non sarebbe stato necessario svolgere delle indagini. Kelley, al contrario, dichiarò che la piattaforma avrebbe effettuato verifiche senza poi trovare nessun’evidenza della discriminazione. Successivamente è stato tuttavia ammesso che fossero chiaramente necessarie ulteriori verifiche.

In seguito Twitter si è pubblicamente scusata, ammettendo l’esistenza del problema e annunciando la pronta modifica dell’algoritmo.

Altri casi rilevanti

Un’indagine dell’American Civil Liberties Union effettuata su Amazon Rekognition, il software per il riconoscimento facciale del colosso fondato da Jeff Bezos, ha mostrato come il sistema abbia confuso i volti di ventotto parlamentari eletti alla Camera e al Senato con le foto segnaletiche tratte da un database della Polizia di 25 mila detenuti. Non si tratta solo di imprecisione. Nel 39% dei casi, intatti, i parlamentari scambiati per criminali erano uomini e donne di colore che però rappresentavano solo il 20% dei 535 esponenti del Congresso messi a confronto con il database.

Tornando invece al web e ai social network, non mancano altri eclatanti casi di discriminazioni legate all’etnia. Nel 2015 il sistema di riconoscimento di immagini di Google catalogò alcune persone di colore come “gorilla”. Un paio di anni dopo un altro sistema della stessa azienda, il Cloud Natural Language API, giudicava negativamente alcune affermazioni su religiosità e sessualità come “sono ebreo” o “sono gay”.

Come hanno mostrato le reazioni disorientate dei manager di Twitter, spesso questi casi svelano le difficoltà nel penetrare la cosiddetta black box in cui sono rinchiusi i calcoli eseguiti dagli algoritmi. Per tenere sotto controllo il problema, Facebook, che ha una lunga storia di precedenti anche con più ampie ricadute su donne e minoranze, ha messo in piedi un team internazionale col compito di verificare se i propri algoritmi, compresi quelli di Instagram, siano in qualche modo contraddistinti da pregiudizi razziali. Sembrerebbe inoltre che altri social network vogliano implementare simili sistemi di controllo.

Riflessioni sommarie

Possiamo affermare che l’adozione di sistemi automatici per la valutazione dei candidati per posizioni lavorative sia sicuramente utile per le grandi aziende che si trovano a dover analizzare centinaia di curriculum. È altrettanto vero, però, che l’adozione massiva di questi sistemi sia deleteria e depersonalizzante. Queste procedure, infatti, annullano l’interazione umana sottoponendo le persone ad un singolo test con cui un IA dovrebbe analizzarle in modo specifico. Senza contare inoltre le ripercussioni psicologiche e la mancanza di istruzioni su come poter imparare dalle esperienze negative.

È davvero accettabile che gli individui debbano essere assunti in base ai piccoli dettagli rilevati durante una registrazione video? Non dobbiamo dimenticare i vizi di forma dovuti all’impersonalità dei test, la situazione psicofisica del candidato (ansia o nervosismo) e i parametri di confronto del sistema. Tutto ciò può portare inevitabilmente al collasso della pratica, in quanto il web ha impiegato ben poco tempo per giungere ad una “soluzione”: la nascita di comunità di discussione dove i “rifiutati” (ma anche gli addetti ai lavori) condividono informazioni sui propri test, in modo da istruire le persone ad aggirare possibili problematiche.

Lo studio americano effettuato sul sistema automatico di assegnazione delle cure dei pazienti è un chiaro esempio di come il fenomeno della distorsione nelle decisioni degli algoritmi sia reale. Le IA si comportano realmente con i pregiudizi ereditati dai dati di addestramento. Non si tratta di fantascienza, ma realtà dei fatti. Sarà necessario rimuovere l’ostacolo per permettere al progresso di andare avanti.

Le responsabilità dei tecnici

Sembrerebbe che per evitare un eccessivo allungamento delle tempistiche di sviluppo, le aziende informatiche e i progettisti non eseguano abbastanza test sugli algoritmi per scovare possibili distorsioni nei dati utilizzati. Né effettuino confronti approfonditi tra i risultati dei sistemi e quelli del processo decisionale umano, prima di presumere che l’algoritmo possa operare scelte migliori. E che tanto meno si formino sul settore e il contesto sociale a cui è destinato il software.

La conseguenza è la presenza di forme di razzismo anche all’interno degli algoritmi utilizzati nella giustizia penale ed altri settori amministrativi importanti. Come spiegato nelle prime sezioni di quest’approfondimento, le forme di discriminazione e pregiudizio messe in atto dagli algoritmi non dipendono dall’algoritmo stesso, ma dai dati utilizzati per addestrarlo.

I social network, data la grande mole di utenti che vi interagiscono, ottengono gratuitamente informazioni e set di dati, ma come già discusso, la popolazione attiva su internet rappresenta una maggioranza che esclude le categorie più deboli. Per cui i dataset in possesso delle piattaforme, che chiaramente rappresentano la loro utenza, possiedono inerentemente una distorsione data dai pregiudizi culturali.

Addestrando gli algoritmi con dati pregiudizievoli, si otterranno sistemi che opereranno in maniera razzista, come nei casi di Twitter e di Google che abbiamo illustrato. È necessario sottolineare come in questi casi il razzismo non sia voluto ma nonostante questo le ripercussioni della problematica legata ai dati distorti si è fatta sempre più rilevante. Cosa accadrebbe se venissero creati algoritmi che discriminano volutamente? Basti pensare a come possano essere anche costruiti volontariamente sistemi che agevolano i contenuti più di tendenza, come per il caso di Instagram.

Il punto della situazione

Concludendo, è chiaro come l’idea idilliaca dell’automatismo e dell’intelligenza degli algoritmi sia pian piano crollata a causa di fondamenta che si sono rivelate avere problematiche inizialmente non previste.

Gli strumenti intelligenti ci sono, e la loro costruzione funziona. Solo nel momento in cui si addestrano i sistemi per comportarsi come umani, utilizzando dati distorti dagli esseri umani stessi, viene a palesarsi il problema. È necessario che la ricerca scientifica soffermi maggiormente i suoi sforzi sull’applicazione di tecniche per ottenere set di dati privi di distorsioni razziali, che non diventino rappresentazione delle problematiche pregiudiziali dell’uomo.

La tecnologia non deve essere il sostituto dell’uomo, ma uno strumento per migliorare ciò che l’uomo può offrire. Sia esso un prodotto o un servizio. E purtroppo, per quanto riguarda la tematica discussa, nonostante gli sforzi della ricerca, non si è ancora arrivati ad ottenere risultati del tutto soddisfacenti. Tuttavia, se l’uomo non è perfetto, come possono esserlo le sue creazioni?

Cosimi S. (2020). L’accusa all’algoritmo di Instagram: “Un circolo vizioso, favorisce le foto seminude”. La Repubblica

Ledford, H. (2019). Millions of black people affected by racial bias in health-care algorithms. Nature, 574(7780), 608-610

Shockman E. (2015). Are algorithms racist — and can we fix that?. The World – Science Friday

Crawford. K. (2013). The hidden biases in big data. Harvard business review, 1(4)

Venkatasubramanian S., & Crawford K. (2015). Are algorithms racist — and can we fix that?. Science Friday

Venkatasubramanian S., Horiuchi V., & Tantibanchachai C. (2015). PROGRAMMING AND PREJUDICE. The University of Utah

Buranyi S. (2018). How to persuade a robot that you should get the job. The Guardian

Venkatasubramanian S. (2015). When an algorithms isn’t…. Suresh Venkat on Medium